KI in der Schule? Ist sie nun einmal da und muss man sich deswegen damit beschäftigen?

Es vergeht kein Tag auf Social Media mit neuen, coolen Tipps zur Nutzung von KI im Unterricht. Ich ziehe seit drei Jahren mit einem Vortrag zu KI durch alle möglichen Gruppen und Gremien, der sich mehr und mehr zu einer sehr kritischen Sicht auf das Thema gewandelt hat.

1. KI-Anwendungen, die Sprache generieren, verhindern Lernprozesse

Verschiedene Forscher und Experten weisen auf gravierende Mängel in Sprachmodellen hin, die das Rückgrat vieler Angebote für den Bildungsbereich bilden. Auch die Auswirkungen auf Lernprozesse werden zunehmen kritisch beschrieben. Bezeichnenderweise kommt die differenzierteste Kritik dabei nahezu immer von Menschen mit informatischem Hintergrund. Verfechter der Nutzung von Sprachmodellen im Unterrichtskontext halten stets dagegen, dass es dabei immer auf die Art der jeweiligen Nutzung ankommt. Davon bin ich nicht überzeugt.

Exemplarisch verweise ich auf eine aktuelle Studie von Rainer Mühlhoff und Marte Henningsen, die sich ein Fobizz-Tool zur automatischen Bewertung von Hausaufgaben genauer angeschaut haben. Von diesen Werkzeugen bzw. Angeboten gibt es mehrere auf dem deutschen Markt, sogar solche, die Gründerpreise erhalten haben. Ihnen gemein ist, dass sie sich auf die gleiche informatische Technologie stützen und sich explizit an Lehrkräfte richten. Die Datenbasis der Studie ist verhältnismäßig gering – das ist leider im Bildungsbereich bei vielen Studien so. Hier einige Auszüge aus den Ergebnissen:

-

Sowohl die vorgeschlagene Gesamtnote als auch das qualitative Feedback variierten erheblich zwischen verschiedenen Bewertungsdurchläufen derselben Abgabe. Diese Volatilität stellt ein ernstes Problem dar, da Lehrkräfte, die sich auf das Tool verlassen, unbemerkt quasi “ausgewürfelte” und potenziell ungerechte Noten und Rückmeldungen vergeben könnten.

-

Selbst mit vollständiger Umsetzung der Verbesserungsvorschläge war es nicht möglich, eine “perfekte” – d.h. nicht mehr beanstandete – Einreichung vorzulegen. Eine nahezu perfekte Bewertung gelang nur durch Überarbeitung der Lösung mit ChatGPT, was Schüler:innen signalisiert, dass sie für eine Bestnote auf KI-Unterstützung zurückgreifen müssen.

-

Das Tool weist grundlegende Defizite auf, von denen die Studie mehrere als “fatale Gebrauchshindernisse” klassifiziert. Es wird darauf hingewiesen, dass die meisten der beobachteten Mängel auf die inhärenten technischen Eigenschaften und Limitationen großer Sprachmodelle (LLMs) zurückzuführen sind. Aus diesen Gründen ist eine schnelle technische Lösung der Mängel nicht zu erwarten.

Die Studie bezieht sich auf die Nutzung von Sprachmodellen durch Lehrkräfte. Dies ist eine Nutzung durch Expert:innen mit entsprechender Erfahrung und Expertise bei der Umsetzung von Bewertungen.

Die weitgehend fachlich unreflektierte Forderung nach flächendeckender Bereitstellung von sogenannten KI-Tools zieht sich sowohl durch die Presselandschaft als auch durch Verbände. Unser Medienzentrum stellt Lehrkräften an Schulen in Trägerschaft des Landkreises tatsächlich einen solchen Zugang bereit. Ich würde mittlerweile darüber nachdenken, diese Bereitstellung an eine vorherige verbindliche Schulung und Sensibilisierung zu koppeln.

In Bezug auf die Nutzung durch Schüler:innen hat Jeppe Klitgaard Stricker für mich bemerkenswerte Thesen bzw. Beobachtungen auf- bzw. angestellt:

- Intellektuelle Spiegelung: Schüler:innen übernehmen unbewusst von LLMs generierte Sprachmuster.

- Digitale Abhängigkeitsstörung: Schüler:innen geraten in Panik, wenn KI-Tools nicht verfügbar sind.

- Die Illusion der Beherrschung: Schüler:innen denken, sie hätten es verstanden, weil AI es erklärt hat.

- Verfall der kollaborativen Intelligenz: Schüler:innen verzichten auf menschliches Brainstorming, wenn KI schneller ist

- Verwirrung zwischen Realität und Prompt: Schüler:innen betrachten Herausforderungen aus dem wirklichen Leben als Prompt zur Optimierung

- Krise des Wissensvertrauens: Schüler:innen zweifeln an der menschlichen Weisheit im Vergleich zur KI-Gewissheit

- KI-induzierter Perfektionismus: Der Druck, die fehlerfreien Ergebnisse der KI zu erreichen

Ich möchte das Wort „Schüler:innen“ hier gerne allgemeiner durch das Wort „Lernende“ ersetzen, denn viele der Punkte dürften ebenso auf Erwachsene zutreffen. Für mich ist diese Perspektive recht neu, weil ich bisher bei meiner Kritik an der Nutzung von Sprachmodellen im Unterricht eher kognitionstheoretisch unterwegs war:

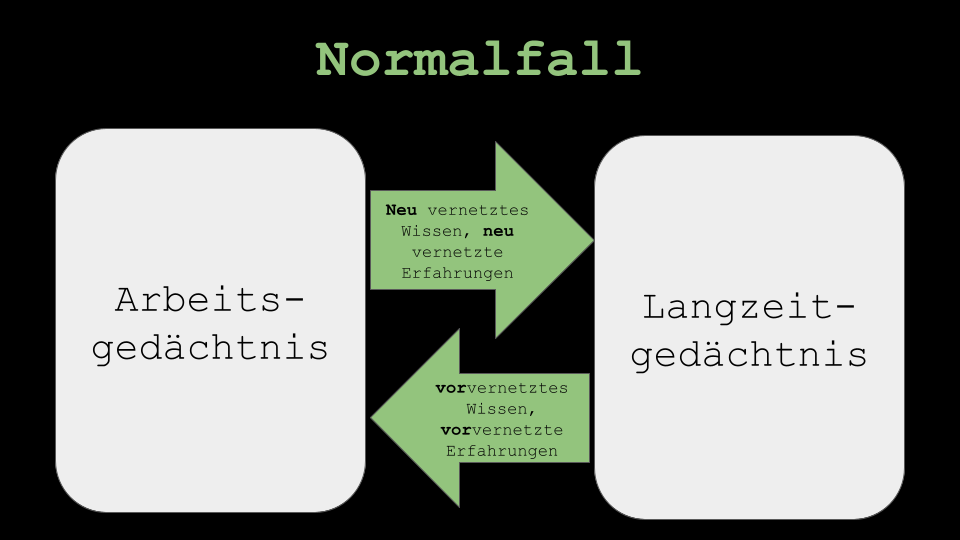

In aller Kürze: Unser Arbeitsgedächtnis enthält das, was wir aktuell denken. Es speist sich u.a. aus dem, was wir im Laufe des Lebens in unser Langzeitgedächtnis übernommen haben. Der Vernetzungsgrad dieses Wissens im Langzeitgedächtnis ist bei erfahrenen Personen (Experten) größer als bei eher unerfahrenen (Novizen). Der Output von Sprachmodellen überlastet die Kapazität des Arbeitsgedächtnisses bei Noviz:innen viel schneller als bei Expert:innen, weil weniger Kompensation durch vorvernetztes Wissen aus dem Langzeitgedächtnis erfolgt.

In aller Kürze: Unser Arbeitsgedächtnis enthält das, was wir aktuell denken. Es speist sich u.a. aus dem, was wir im Laufe des Lebens in unser Langzeitgedächtnis übernommen haben. Der Vernetzungsgrad dieses Wissens im Langzeitgedächtnis ist bei erfahrenen Personen (Experten) größer als bei eher unerfahrenen (Novizen). Der Output von Sprachmodellen überlastet die Kapazität des Arbeitsgedächtnisses bei Noviz:innen viel schneller als bei Expert:innen, weil weniger Kompensation durch vorvernetztes Wissen aus dem Langzeitgedächtnis erfolgt.

Natürlich ist KI z.B. bei der Erstellung von Seminararbeiten in jeder Phase nutzbar. Zu prüfen ist aber sehr genau, in welchem Umfang das für Noviz:innen mit sehr heterogenem Vernetzungsgrad – so sind Lerngruppen zusammengesetzt – im Langzeitgedächtnis sinnvoll ist.

Unter Berücksichtigung der bisherigen Prämissen sind Sprachmodelle erst dann lernförderlich nutzbar, wenn bei den Noviz:innen bereits ein gewisses Maß an vernetztem Vorwissen vorhanden ist. Unverantwortlich wird für mich eine unterrichtliche Thematisierung allein auf der Benutzungs- und Bedienungsebene.

Expert:innen hingegen können wahrscheinlich zwar die Ausgaben von Sprachmodellen deutlich besser bewerten, sie aber ohne ein Grundverständnis für deren Funktion nicht reflektiert nutzen. Wer lässt denn z.B. den gleichen Text mehrfach durch ein KI-Werkzeug bewerten und vergleicht die Ausgaben dann zusätzlich miteinander, wie es in der zitierten Studie geschehen ist? Zudem ist das Marketingversprechen der Zeitersparnis damit ziemlich schnell hinfällig. Auch Expert:innen sind tendenziell „anfällig“ für die von Stricker formulierten Mechanismen.

2. Produkte von KI-Anwendungen sind das neue Plastik und kontaminieren den Kommunikationsraum des Internets

Unter anderem von Linux Lee kommt die Idee, Produkte generativer KI analog mit aus Erdöl hergestelltem Plastik zu sehen. Genau wie das Erdölprodukt unserer fassbare Welt füllt, füllen die Produkte generativer KI (Musik, Bilder, Videos, Texte etc.) den kommunikativen Raum des Internets.

Im Zuge von Nachhaltigkeitsdenken gerät Plastik schnell in eine negative Ecke, ist aber als Werkstoff aus einer modernen Gesellschaft an vielfältigen Stellen nicht wegzudenken. Ein gravierender Unterschied besteht darin, was man mit vorhandenem Plastik machen kann. Prinzipiell ist Plastik aus Erdöl recyclebar, nur ist das weder wirtschaftlich noch gibt es entsprechende Steuerungsmechanismen in der Produktions- und Verwertungskette, die das überhaupt ermöglichen würden. Bei einem gut strukturierten Plastikkreislauf ist eine Mehrfachnutzung des Werkstoffs ohne sehr große Qualitätseinbußen prinzipiell denkbar.

Je mehr Produkte generativer KI in den Kommunikationsraum des Internets gelangen, desto wahrscheinlicher ist die Gefahr, dass sie wiederum selbst die eigentlich Trainingsbasis für KI werden. Man spricht dabei von einem sogenannten „Rebound-Effekt“. Mehr oder weniger humorvoll wurde bezogen auf das Bildungswesen die These formuliert, dass irgendwann eine „Lehrkräfte-KI“ die „KI-Hausaufgaben“ der Schüler:innen bewertet. Ironischerweise liefert die Studie von Mühlhoff und Henningsen ja genau dafür eine „Anfangsevidenz“. Im Gegensatz zum Plastik aus Erdöl ist die Ressource „Produkt einer generativen KI“ nicht wirklich begrenzt, wenn z.B. regenerative Energie zu deren Produktion genutzt wird. Damit gibt es kein wirkliches Interesse oder gar eine Notwendigkeit, diese Produkte zu regulieren. Allein die kritische Betrachtung von KI im Bildungskontext wird durchaus mit Innovationsfeindlichkeit in Verbindung gebraucht.

Das wiederum hat damit zu tun, dass KI oft nicht differenziert betrachtet wird: Mit ähnlichen informatischen Mechanismen kann eine KI Sprache erzeugen oder aber sehr effizient Proteinstrukturen in der Entwicklung von Medikamenten berechnen. Das können nachhaltige Produkte werden, wie sie auch beim Plastik aus Erdöl möglich sind. Beides „ist“ KI.

Letzteren Einsatz von KI würde ich deutlich anders bewerten, da das entstehende Produkt auf eine völlig anderen Ebene Wirksamkeit entfaltet. Diese Unterschiede in der Betrachtung vermisse ich in der gesellschaftlichen Diskussion. Gerade im Bildungsbereich ist das Thema meist marketing- und buzzwordgeschwängert und trifft auf eine informatisch meist nicht ausreichend vorgebildete Zielgruppe.

Ja, was soll man denn machen? KI ist ja nunmal da!

… und geht nicht wieder weg. In einer Rede zum Abitur meines Sohnes habe ich beschrieben, dass die Möglichkeit, sich entscheiden zu können, eine Luxussituation ist. Tatsächlich kann man sich dafür entscheiden, Sprachmodelle im Unterricht nicht zu nutzen. Ich persönlich tue mich schwer damit, längere Textproduktionen ist die Hausaufgabe zu geben – das mache ich lieber im Unterricht, z.B. in Kombination mit kollaborativen Schreibwerkzeugen. Die entstehenden Produkte stellen schon eine eigenständige Leistung dar. Sehr gut funktioniert eine orthografische und grammatische „Nachkontrolle“ durch ki-basierte Werkzeuge. Gerade in der Mittelstufe sollten die Kompetenzen zur Bewertung der „KI-Eingriffe“ in diesem Bereich im Prinzip schonmal im Schulleben vorgekommen und „vorvernetzt“ im Langzeitgedächtnis vorliegen – eigentlich.

Eine der wesentlichen Hauptaufgaben von Bildung wird sein, wie man vermitteln kann, dass bestimmte Dinge gekonnt werden sollten, bevor KI zum Einsatz kommt – gerade weil die Maschine es doch so viel besser kann. Und das nicht nur bei Schüler:innen sondern vor allem auch bei uns Lehrkräften.

Wenn wir darüber nachdenken, landen wir sehr schnell bei strukturellen Überlegungen zum Bildungssystem an sich.

„Ach, Luise, lass … das ist ein zu weites Feld.“ (Theodor Fontane)

Pingback: ats20.de

Pingback: 24-12-19 Liste von Filmen, die in „The Holiday“ empfohlen werden (18×0- (13,7)) – iberty.de